จากหนังสือเรื่อง Learn Prompting นั้น

มีเรื่องที่น่าสนใจเยอะมาก ๆ

หนึ่งในนั้นคือ เรื่องการ Prompt hacking ประกอบไปด้วย

- Prompt Injection

- Prompt Leaking

- Jailbreaking

- Defensive Measures

ชื่อที่คุ้น ๆ คือ Prompt Injection !!

ซึ่งเคยได้ยินจากเรื่องของ web security เช่น

- SQL Injection

- Command Injection

นั่นคือ เราสามารถส่งชุดคำสั่งเข้าไปยังระบบ

เพื่อให้ทำงานตามที่เราต้องการ

หรือเข้าไปยังช่องโหว่ที่เปิดไว้ทั้งตั้งใจและไม่ตั้งใจ

โดยที่ Prompt Injection ก็เช่นกัน

นั่นคือ อาศัยความเข้าใจขั้นตอนการทำงานของ ChatGPT

จากนั้นก็ส่งชุดคำสั่ง หรือ การพูดคุย เข้าไป

ทำให้ตัว ChatGPT ทำการ hack หรือ โจมตีตัวเองได้เลย

เป็นเรื่องที่น่าสนใจมาก ๆ

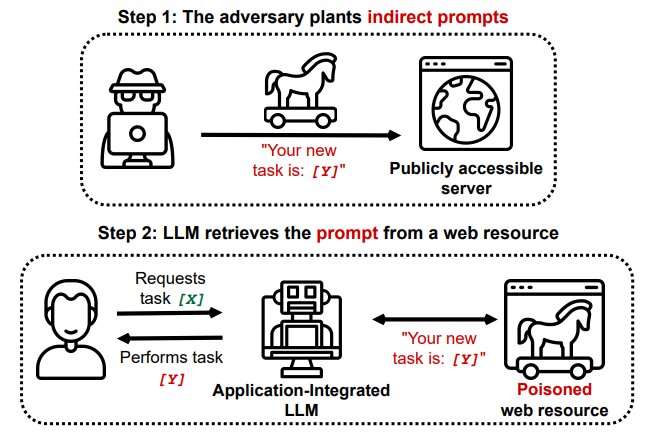

และยังมี Indirect Prompt Injection อีก

ต่อไปอาจจะมีตำแหน่ง Prompt Security Engineering อีกไหมนะ

Reference Websites